'전체보기'에 해당되는 글 48건

- 2026.01.26 안녕 Evernote

- 2025.10.28 코르딕스 Cordix 캐리어 사용기

- 2025.10.20 아버지와 함께한 타카마츠 여행기

- 2025.10.14 포닥을 관둔지 두달이 지났다.

- 2024.04.04 포닥을 시작한지 한달이 지났다.

- 2024.02.29 해외에서 번호이동 1

- 2023.01.23 정경수의 <계획 세우기 최소원칙>을 읽고

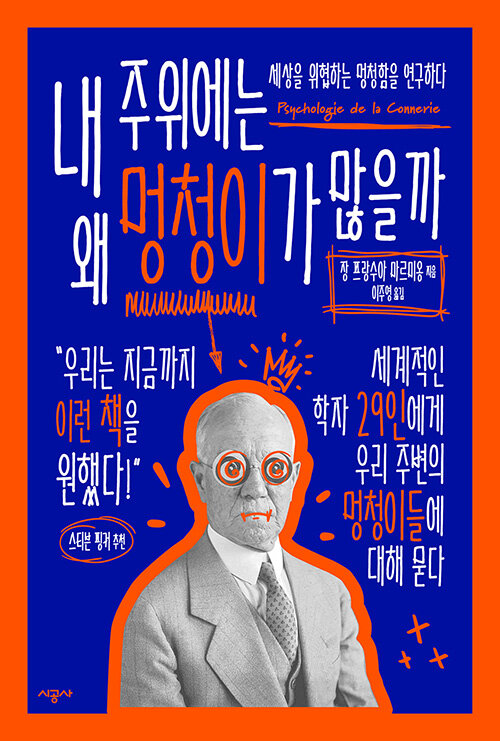

- 2022.12.19 장 프랑수아 마르미옹의 <내 주위에는 왜 멍청이가 많을까>를 읽고

- 2022.11.28 달라이 라마의 <종교를 넘어>를 읽고

- 2022.10.19 [Matlab] 2D Gaussian Convolution

초창기에 "클라우드"의 개념을 아무도 모르던 시절에 혜성같이 등장한 Evernote.

첫인상도, 쓰는 와중에도 계속 느껴왔던 것이지만, 클라우드 기능이 추가된 워드패드 그 이상도 이하도 아니라 미묘한 포지션이었습니다. 그래도 한 기기에서 작성한 노트를 다른 기기에서 바로 볼 수 있다는 것은 정말 혁신적이라고 생각했던 기억이 있어요. 기술에 대해 잘 모르시는 분들께도 Dropbox와 함께 '아, 이것이 클라우드라는 것이다'를 설명하기에 아주 좋은 예시였죠.

다양한 경쟁자가 등장했음에도 가격과 극도로 효율화된 동기화 기능 때문에 살아남은 Dropbox와 달리, 기존 기능을 거의 그대로 고수했던 Evernote는 하향길로 접어들었습니다. Bending Spoon에 인수된 뒤로 무언가 변화가 생길 줄 알았는데, 긍정적인 변화는 보기 어려웠습니다.

하긴, 단순한 노트앱으로는 사용자를 모으기가 너무 어려울 것 같고, 강력한 경쟁자인 Notion에 비해 더 나은 점도 없었어요.

한때는 몰스킨과 콜라보한 노트 제품을 사기 위해서 홍콩에 가기도 했었는데, 결국 무료버전에서는 접속 가능한 기기를 1대로 제한하는 것을 보고 탈퇴를 결심했습니다. 암호화 기능을 사용해서 일기를 쓰거나, web clipper를 자주 사용했는데 백업기능이 없기에 하루가 꼬박걸렸습니다. 저는 그래도 노트가 300개 남짓 있었는데 1000개가 넘어갔다면 그냥 정말 필요한 것만 빼고 다 지웠을 것 같네요.

'취미 > Technology' 카테고리의 다른 글

| [Matlab] 2D Gaussian Convolution (0) | 2022.10.19 |

|---|---|

| Notion 입문 1달차 (0) | 2022.02.23 |

| tensorflow에서 시작하는 pytorch 작동 방식 (iris example) (0) | 2022.02.03 |

| Notion 입문 1일차 (0) | 2022.01.11 |

| 웹캠이 흑백으로 나와요. 해결방법(feat. 뒤늦은 삼성 노트북 A/S 후기) (3) | 2021.08.19 |

2024년 3월 미국으로 포닥을 가기 위해서 위탁이 가능한 사이즈 중 제일 큰 캐리어가 필요했다. 망가진 캐리어나 설계가 잘못된 캐리어로 여행 내내 성가셨던 적이 항상 있었기에 상당히 고심을 해서 골랐었다. 무엇보다 한국 — 미국을 왕복하며 어지간히 학대(?)될 운명이었기에 비싼 돈을 주더라도 좀 좋은 것을 사고자하는 욕구가 컸다.

바퀴 > 바퀴 > 바퀴 > A/S > 가격 >내구도 >>>>> 디자인

먼저, 위와 같은 기준으로 캐리어를 골랐다.

내구도

아메리칸 투어리스트, 샘소나이트 등 나름 국제적으로 이름이 있는 업체가 아닌 타 업체에서 파는 캐리어 제품 상세 설명란에 들어가면 내구도 테스트 사진은 꼭! 있다. '대체 저렇게 유리창 처럼 부서지는 캐리어는 어디서 산단 말인가?' 라는 생각이 들 정도로 처참히 부서진 캐리어와, 그 옆에 멀쩡한 "자사" 캐리어. 살면서 단 한번도 캐리어 본체가 부서진 적이 없었고, 업체들이 어지간히 신경써서 만드는 것 같기에 크게 고려를 하지 않았다.

디자인과 가격

대체 캐리어를 왜 디자인을 보고 고르는거임? '생애 첫 해외여행❤ 유럽 갑니다 ✈✈' 정도면 그럴 수 있어도 약간.. 신발 살때 바닥 패턴의 미적 아름다움을 보고 결정하는 것 같다. 파스텔 핑크나 옐로 캐리어 딱 한번 쓰면 시커멓게 스크래치 생겨서 오는데 여행 안다녀본 사람이나 색보고 고른다.

그리고 보통 컬러를 넣거나 미적으로 예쁘게 캐리어가 나오면 가격이 1.5배, 2배씩 뛰더라. 나도 예쁜 캐리어들이 눈에 자주 들어왔으나 유혹을 떨쳐내기 힘들었다.

바퀴

그럼 캐리어들의 차별성은 어디서 오느냐, 바퀴에서 오는 것 같다. 업계 최고라고 불리우는 히노모토 바퀴를 한번이라도 끌어본 사람은 '아 캐리어는 끌고가는게 아니라 굴러다니는 것이구나'를 알게 된다. 사실 이 때문에 히노모토 바퀴를 사용하는 로우로우를 고려했었는데 과한 디자인과 가격으로 탈락! 오프라인 샵에서 만져보니 역시 업계 최고가 맞고, 디자인도 정말 예쁘더라.

그 외의 국내에서 파는 업체들은 거의 자체제작 바퀴를 쓴다. 결국에 어떤 구조로 바퀴를 만들었는지 알 방법이 없으니 각 회사의 제품 상세 설명을 보고 골랐었는데, 리드볼트와 코르딕스 중 고민하다가 결국 코르딕스로 했다.

아래는 1년반 사용기

본체가 엄청 가벼워서 놀랐다! 이거 제품 상세란에 있는 '타사' 상품 처럼 볼링공에 구멍나는거 아니야? 하고 걱정했지만, 그런 일은 없었다. PC 재질이었나? 이게 이렇게 말랑하고 튼튼할리가 없는데.. 어찌되었건 본체 내구도에 있어서 큰 문제는 없었다.

심지어 상당한 악조건에서 캐리어를 굴렸다. 캐리어를 32KG 최대 한도까지 꽉꽉 채우고, 내부는 옷가지류가 아니라 컴퓨터, 전동드라이버 등 상당히 중량이 나가고 딱딱한 물건들로만 채워서 갔었는데 정말 멀쩡했다!

후기들을 자주 보다보면 모서리 부분의 금속 보호부품이 손상이 된다고 한다. 나도 거의 모든 모서리가 휘어져있었으나, 저게 받혀주지 않았다면 진짜 본체가 깨졌었겠지... 사람 반명 분의 무게를 담고 우당탕탕 굴러다닌 상태 치고 난 충분히 만족했다.

이 바퀴로 말할 것 같으면 32KG의 짐을 넣고 도쿄 시내를 누비고 20cm 정도 눈이 쌓인 흙길을 지나가며 제대로 포장이 안된 미국 도로를 다닌 바퀴다. 상당히 험한 환경에서 굴렸다 생각하는데 아직까지 삐걱거림 없이 잘 굴러간다. 솔직히 눈길을 끌고 갈때는 캐리어를 버릴 작정으로 무작정 끌고 갔다. 용캐 살아남은 것을 보니 내구성 합격!

유일한 이슈. 워낙 짐을 많이 넣고 다녀서 그런지, 아니면 이렇게 지퍼 없이 작동하는 캐리어 특성인지 윗판과 아랫판의 유격이 생겼다. 닫을 때 윗판과 아래판을 잘 정렬해서 닫지 않으면 캐리어가 닫히지 않는다. 아래 사진에 보면 모서리 부분에 긁힌 자국이 보이는데, 유격이 생기면서 위쪽 접촉부가 휘어져서 아래쪽 접촉부를 긁고 있는 것. 다행히 어느정도 연성이 있는 금속을 사용해서 플라이어로 펴주면 잘 닫힌다.

총평

20만원도 안되는 가격에 충분히 바랄만한 요소는 다 들어가 있었다. 바퀴 내구도도 충분했고, 위탁 수하물 최대 중량을 꽉꽉 채워서 다닌 친구 치고 접합부나 유격 이슈가 크게 나타나지는 않았다. 손잡이의 안정성이나 어디 하나 불만스러운 곳은 없었다. 바퀴의 매끄러움은 히노모토 바퀴의 한 80% 정도. 낫뱃 낫뱃.

당시 기억을 되돌려보면 로우로우를 보고 침 한번 흘리고, 리드볼트랑 코르딕스에서 고민을 하다가 할인 들어간 것을 보고 코르딕스를 고른 것 같다. 12년 무상 수리도 결정에 한몫했던 것 같다. 지금 같은 제품은 28만원대, 리드볼트가 31만원대 정도이다. 엄청 올랐네... 다음 제품도 코르딕스를 고르거나 리드볼트를 한번 시도해보지 않을까 싶다.

'취미 > New Things' 카테고리의 다른 글

| 3세대 항히스타민제 알레그라정 (한독약품) (0) | 2022.01.10 |

|---|

백수 기념(?)으로 아버지와 타카마츠로 여행을 다녀왔다. 외래어 표기법상 다카마쓰가 맞지만 현지 지도에서 da ka ma su로 일본어를 쳤다가 혼란에 빠진 일이 있었기에 원래 표기 たかまつ (takamatsu)로 계속 언급하겠다. 작년 스페인 여행에서 영원한 여행메이트 아버지와 어려움이 있었기에 이번에는 큰 기대를 안 하고 출발을 했다. 도시 자체도 시골이기도 하고 유유자적 돌아다니면 되겠다 싶어서 상대적으로 부담감이 덜한 여행이었다.

타카마츠는 일본의 크게 4개의 섬 중 가장 작은 시코쿠(四国) 섬 북쪽에 위치해 있다. 왜 4국인가 했더니 과거 4개의 나라가 있었기에 그리 불린다고 한다. 특히 가장 큰 중앙섬인 혼슈(本州)와 가장 가까운 곳을 '세토 내해'라고 하는데, 한국의 남해안처럼 섬들이 많은 지형이고 물류의 중심으로도 기능했다고 한다. 태평양을 바로 마주 보고 있지 않아서 그런지 바다도 잔잔한 느낌이었다.

0일 차

타카마츠의 주 관광상품은 이 세토 내해에 속해있는 다양한 섬들과 우동이다. 마침 우리가 가는 시즌에 세토내해 트리엔날레라는 행사를 하고 있었다. 가타가나만 보고 '트리엔.. 뭐?' 했는데 원래부터도 모르던 단어였다. 3년마다 개최되는 예술제라 트리엔날레라고 한다는데 2년마다 개최되는 비엔날레를 떠올리면 '아하~'하게 되는 대목이다. 특히 일본의 유명 건축가 안도 타다오가 설계한 건축물과 작품들이 섬 곳곳에 흩어져 있어서 이를 둘러보는 재미가 있다고 한다. 올해 개최되는 예술제에서는 거의 대부분의 미술관과 박물관을 무료로 들어갈 수 있는 예술제 여권을 팔았다. 4,500엔의 가격이었는데 하나하나 예약을 하고 돌아다니는 것보다 이쪽이 나을 것 같아서 여권을 구입했다.

두 번째로 유명한 것은 타카마츠 바로 옆에 붙어있는 '사누키', 사누키 우동이다. 각종 여행 정보지와 블로그를 찾아보고 내린 결론은 '사누키 우동 = 평양냉면'이다. 평양냉면이 마니아들 사이에서는 어디가 면발이 어떻고 국물의 염분이 어떻고, 여긴 반죽을 어떻게 하고 등등 미묘한 맛을 즐기며 소비된다. 그러나 자극적인 맛에 익숙해진 많은 사람들에게는 '행주 삶은 물에 말아주는 국수'라고 치부되기도 한다. (지금은 평양냉면이 가끔 생각날 정도 좋아하는 편이긴 하지만 첫 만남에 저 표현보다 더 정확한 말을 못 들었다) 그래서 슴슴하니 집집마다 미묘한 차이가 있는 음식이라는 마인드셋을 장착하고 출발했다.

공항 안 안내 데스크에서 예술제 여권을 구입한 뒤 시내로 이동하니 오후 6시 반이 되어 있었다. 우동을 제외하고는 오사카처럼 특별히 유명한 음식이 있지 않아서 아버지와 이곳저곳 돌아다니기로 했다. 처음 방문한 곳은 덴뿌라 전문점 大銀.

가격이 1,500엔 대로 싸서 살짝 의심을 했는데, 재료는 신선했다. 자주 가는 신주쿠 덴뿌라집과 비교하면 납득이 가는 맛이었다. 관광객들이 상당히 많이 오는 지역임에도 불구하고 가게들은 대체로 현지인 위주로 돌아가는 인상이 많았다. 여기도 딱 봐도 일본어 못할 것 같은 외국인은 사전 예약제라면서 쫒아내더라.

2차로 갈 곳을 찾는 도중, 덴뿌라 집을 찾아갈 때 현지인들이 잔뜩 줄 서 있던 곳을 발견했어서 그곳으로 발걸음을 옮겼다. 아버지는 이전에도 드셔보신 적이 있다고 하신 요리인데, 아버지의 이번 여행의 주목적 중에 하나였다. 닭다리를 뼈째 구워서 한쪽 면을 바싹 익혀서 주는 닭 요리, 호네츠키토리이다. 곳곳에 파는 가게가 있었는데 가기 전에 새로운 가게를 시도하지 않고 다시 이 가게로 왔을 정도로 만족할만한 맛이었다. 또 온다면 무조건 재방문할 집.

3차로는 나 혼자 밖에 나왔다. 술도 거하게 마신 상태로 휘청거리며 특색 있는 가게를 찾다가 조용한 사케집을 발견했다. 외관상으로는 토킹바의 분위기가 물씬 났고, 가게 안에 들어가서 5분가량은 비슷한 걱정을 했는데 기우였다. 마침 옆자리에 앉아계시던 포켓몬 카드를 모으시는 회사원 아저씨랑 친해져서 사장님과 셋이서 2시간 반 가량 수다를 떨었다. 아저씨는 공무원을 하신다고 하셨는데 나이도 지긋하신 게 상당히 높은 자리에 계신 게 아닌지. 사장님은 95년생 젊은 여성분이셨는데 가게 계산을 하고 나서 3번은 카드 값을 확인했을 정도로 엄청난 미인이셨다. 술 추천도 잘해주시고 사케를 잔으로 팔아서 원 없이 마시고 온 것 같았다. 상당히 마신 것 같았는데 45달러만 나오다니...! 중간에는 자기 뒷산에서 따온 송이버섯이라며 송이버섯 찜도 서비스로 주셨다. 옆에 아저씨도 잘 마신다며 한잔을 사주셨는데 역시 술이 들어가야 일본어가 나오는 것 같다.

1일 차

다음 날은 거의 좀비처럼 다녔다. 아무래도 여러 종류의 술을 섞어서 그런지 아침도 겨우 먹겠더라. 아침은 전날 사장님이 추천해 주신 우동집으로 갔었는데 그냥 그랬다. 첫 사누끼 우동의 인상은 안 좋았던 것으로.. 원래 계획은 오전 8시 배를 타고 섬으로 넘어가는 것이었으나, 아버지도 안 일어나시고 (알고 보니 전날 4시까지 일을 하셨다며..) 나도 죽어가고 해서 결국 12시 40분 배를 타고 나오시마로 이동했다.

13시 30분에 섬에 도착하고, 박물관을 계속 둘러본 뒤, 다시 선착장으로 온 게 15시 30분이니 2시간 만에 싹 돈 것 같다. 섬에 있는 예술품의 대부분이 설치미술이나 공간 그 자체라 either 엄청 여유를 가지고 그 공간을 온몸으로 느끼거나, 안 그러면 쓱 보고 지나거나 둘 중 하나였다. 애매한 시간에 섬에 도착을 했고, 돌아가는 17시 페리가 만선이 될 수도 있다는 현지 안내인 경고에 빠르게 돌아다녔다. 회화의 경우는 하나하나 주의 깊게 작품을 감상하고 움직이지만 설치 미술의 경우 의미를 알 수 없는 작품들은 바로 스킵하고 넘어갔기에 가능했던 것 같다. 아래는 마음에 들었던 작품들의 일부.

무려 1시간 30분 전에 선착장에 도착을 했음에도 불구하고 우리 앞에는 수백 명의 사람들이 대기를 하고 있었다. 배 정원이 256명이었는데 결국 추가 배편을 확보하여 남은 인원들을 시코쿠로 보낼 수 있었다. 분명 페리가 만원이 된 적은 없다고 하던데 예술제 기간은 다른 것 같다.

겨우겨우 섬에 도착한 우리는 전철역으로 몰려가는 사람들을 보며 저녁을 근처에서 해결하기로 했다. 마침 JR 타카마츠 역이 있는 건물 근처에 우동집이 있기에 우동을 다시 시도해보기로 했다. 결과는 환상적. 타카마츠에서 먹은 4곳의 우동집중 유일하게 재방문한 곳이 되었다. 나중에 찾아보니 유명 우동집의 체인이라고 한다. 역시 일본에서는 잘 모르겠으면 대형 쇼핑상가 위층에 있는 식당가에 가는 것이 제일 믿을만 하다. 거의 대부분 전국의 맛집들이 들어와 있고, 관리도 잘 되는 것 같으니 말이다. 우동집 이름은 혼카쿠 테우치 모리야. 본격 수제 모리야이다. 아침에는 해장이 필요해서 가케우동을 먹었으나, 이 가게부터는 면의 맛을 제대로 즐기기 위해서 자루 우동을 시켜서 먹었다.

이 가게는 바로 튀겨내는 제대로 된 덴뿌라도 주는 곳이었기에 선택했다. 아버지를 맨날 100년된 일본 상위급 덴뿌라 가게에만 모시고 갔더니 아침에 먹은 우동집에서 '티김이 별로다'라고 하시길래 한 선택이다. 개당 1500원짜리를 한 코스 5만원짜리에 비교하시면 안되죠.. 예상대로 엄청 만족해 하셨다. 하나 걱정했던 '국물이 왜 이러냐'는 사누키 우동이 면으로 먹는 것임을 납득을 하셨는지 괜찮았던 것 같다. 개인적으로는 이 시점에도 역시 해장이 필요했었기에 누구보다도 국물이 절실했다. 조개탕이라던가 조개탕이라 던가...

그 와중에도 2차를 놓치지 않고 닭꼬치 집으로 안내했다. 해산물을 맛있게 파는 가게가 있었는데 '회는 한국이 더 낫다'는 아버지 말에 방향변경. 중간에 Loft에 들러서 쇼핑을 조금 해주고 근처 닭꼬치 집을 찾아갔다.

2일차

이날의 일정은 리츠린 공원과 온천이었다. 아침 일찍 우에하라야 본점을 오픈시간에 맞춰서 방문했는데 대기가 없었다! 여기도 유명한 우동집 중에 하나인데 평범한 맛. 신경쓰고 먹으면 면이 확실히 다르다는 것을 알 수 있었지만, 전날의 우동만큼은 아니었다. 덴뿌라들은 전반적으로 기름져서 썩 좋지 않았다.

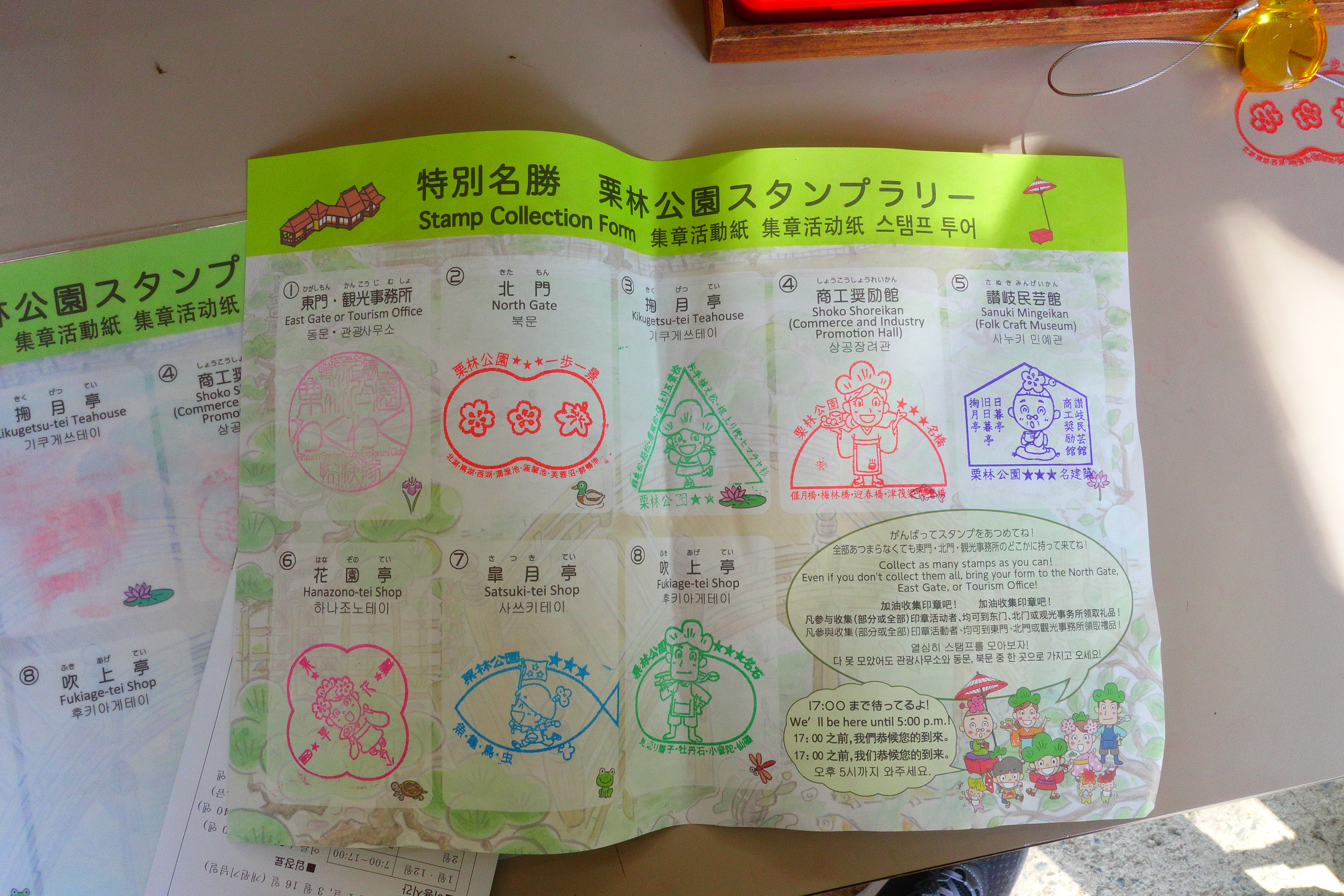

아침의 리츠린 공원은 조용했다. 일본의 3대 정원이라 불리운다는데 크기도 크기지만 여름도 가을도 아닌 이 미묘한 계절에 왔어도 볼만했다는 점을 생각해보면 상당히 좋았던 것 같다. 자연 경관을 보면 인지 부하를 낮춰준다는 Attention Restoration Theory를 찾아보며 인공 섬과 물이 함께있는 풍경을 보다보니 '아 나도 이런 뷰가 보이는 다도실을 가지고 싶다'는 생각을 하게 되었다. 스탬프 랠리가 있기에 공원을 쫙 돌면서 도장을 받는 재미도 있었던 것 같다.

그리고 잉어가 정말 많았다. 수백 마리는 있지 않을까. 어디를 가든지 수면 위로 얼굴을 내밀고 밥을 달라고 몰려있는데 조석 작가의 조의 영역이 생각나더라. 조금 무서울 정도.

이후 점심으로는 개인적으로 제일 가보고 싶었던 덴뿌라가 맛있다는 우동집, 치쿠세이를 방문했다. 이곳이야 말로 가장 조사했던 평들과 일치했던 곳이지 않나 싶다. 무난히 맛있는 면과 정말 맛있는 덴뿌라! 가장 많이 먹는 메뉴가 치쿠와랑 계란튀김을 같이 시키는 것이었는데 뭣도 모르고 키스와 치쿠와를 시켰다. 치쿠와는 살면서 먹어본 것 중에 제일 맛있었다. 대체 뭐로 만든 치쿠와이길래 튀겨도 이렇게 맛있지..! 여기도 줄을 선다는 이야기를 듣고 걱정했었는데 대기 없이 들어갔다. 12시가 되니 직장인들 줄이 5명 정도 잠깐 생겼었던 것뿐.

가와라마치 역으로 돌아온 우리는 자유시간을 가지기로 했다. 나는 그동안 loft와 녹차가게를 방문했다. 정말 오래된 녹차집이라 현지인 대상으로만 영업하지 않을까 했는데 외국인인 내게도 친절히 대해주셨고, 거기서 사온 호지차가 정말 맛있다. 지금도 마시고 있는데 이것도 살면서 마셔본 호지차 중에서 제일 으뜸이 아닐까 싶다.

저녁으로는 호네츠키토리를 다시 먹고 이번에는 온천으로 향했다. 사전에 조사해 둔 온천 중 한 곳이 너무 '현대'적이라 탕도 적고 좁다는 평을 보게 되었다. 댓글을 남기는 방식을 보니 누가 봐도 국밥이랑 탕에 대해서는 평이 까다로울 것 같은 아저씨의 느낌이 물씬 나기에 이름 모를 그이의 평을 믿고 다른 곳인 포카포카 온천으로 향하게 되었다. 이름이 너무 구려서 빼둔 곳이었는데, 실제로는 대성공이었던 것으로.

가장 가까운 역인 오타역에서 상당히 멀어서 (1.6km) 25분 정도 걸어야 했는데, 그리 좋은 선택은 아니었던 것 같다. 돌아가는 길은 그래서 우버를 타고 (1,040엔) 돌아왔다. 내부 시설은 충분히 깔끔했고, 시끄러운 관광객들도 없었으며, 탄산수 온천이 정말 마음에 들었다.

3일 차

이렇게 안전히 여행을 마무리하고 돌아가는 줄 알았으나... 마지막 날 가와라마치 역에서 소매치기에게 지갑을 털리고 말았다. 살면서 두 번 지갑을 도난당했었는데 모두 일본에서 발생했다. 소매치기가 그렇게 많다는 유럽에서도 별일이 없었는데 말이다. 일본, 치안이 나쁘다! 다행히 이번에는 지갑에 돈을 그다지 넣고 오지 않아서 금방 포기해 버릴 수 있었으나, 혹시 학생 할인이 되지 않을까 싶어서 가져온 예일대 신분증은 영원히 사라져 버렸다. 그래, 놓아줄 때도 되긴 했지.

총평

기대했던 대로 우동과 섬 관광이 메인인 작은 소도시였고, 호네츠키토리는 정말 맛있었다. 다음에 여행을 온다면 섬을 좀 더 느긋하게 보고 싶기는 한데, 미리 예약이 필수인 것 같다. 또 예약 없이 갔던 미술관들도 그냥 그랬어서 다시 올만한 장소인지는 모르겠다. 우동은 확실히 맛이 있었는데 다른 도시의 장점들을 포기하고 굳이 찾아가서 먹을 만큼은 아니었다. 한 번쯤은 가볼 만 하지만 여러 번 방문할만한 곳은 아닌 장소. 아마 반려가 궁금해한다면 3박 4일 일정으로 한번 더 오지 않을까.

포닥을 그만둔 지 두 달이 지났다. 2025년 7월 31일이 마지막 근무일이었으니, 실제로는 두 달하고도 보름쯤 된 셈이다. 그만둬야겠다는 생각을 하기 시작한 건 꽤 오래전 일이고, 이후의 삶을 충분히 그려왔기 때문에 지금의 일상이 특별히 낯설지는 않다. 어디에도 속해 있지 않다는 사실이 불안하게 느껴질 줄 알았는데, 생각보다 그렇지 않았다. 일이나 사람으로 인해 나를 찾아주는 이들이 많아서 예상보다 더 바쁜 나날을 보내고 있다.

시간적·금전적 여유가 있음에도 불구하고 왜 이렇게 건강한 습관을 만들기 어려운지, 왜 새로운 일을 시작하는 게 겁이 나는지, 왜 루틴이 쉽게 잡히지 않는지 자주 생각한다. "백수, 생각보다 어렵고 바빠."라며 친구들에게 농담처럼 말하곤 한다. 마치 '바쁨 불변의 법칙'이라도 있는 것처럼, 이제는 하지 않아도 될 생각들로 머릿속은 여전히 쉴 틈 없이 돌아간다. 두 번째 포닥 라운드를 기다리며, 아마 내 인생에서 가장 긴 방학을 보내고 있는 중일지도 모르겠다.

일상 업무에 치이다가 갑자기 시간이 '턱' 하고 주어지니, 자연스레 삶에 대해 더 깊이 생각하게 되었다. 남자는 50대가 넘으면 호르몬 문제로 두 번째 대격변을 맞이한다는데, 나는 조금 일찍 그 과정을 경험하는 기분이다. 가장 근원적인 질문은 결국 "나는 무엇을 좋아하는가?"였다. 나를 과학자의 길로 이끈 원동력이자, 수많은 취미의 근원이자, 올해 초 잠시 잃어버렸던 바로 그 ‘좋아함’의 문제다.

하고 싶은 일과 좋아하는 일들을 나열하고, 왜 하고 싶은지, 어떤 점이 좋은지를 Obsidian에 정리해보았다. 예전에는 좋아했지만 지금은 그렇지 않은 것들도 내 호오(好惡)가 나아갈 방향을 알려줄 단서가 될 것이라 기대했다.

곧 결혼을 앞두고 유부남들에게 조언을 구했을 때, 하나같이 "네 취미용품을 미리 사둬라. 심지어 앞으로 네가 좋아하게 될지도 모르는 취미용품까지 말이야."라고 말했다. 미래의 '좋아함'까지 미리 알 수 있다면, 인생의 선택도 조금은 더 현명해질 수 있지 않을까 생각해본다.

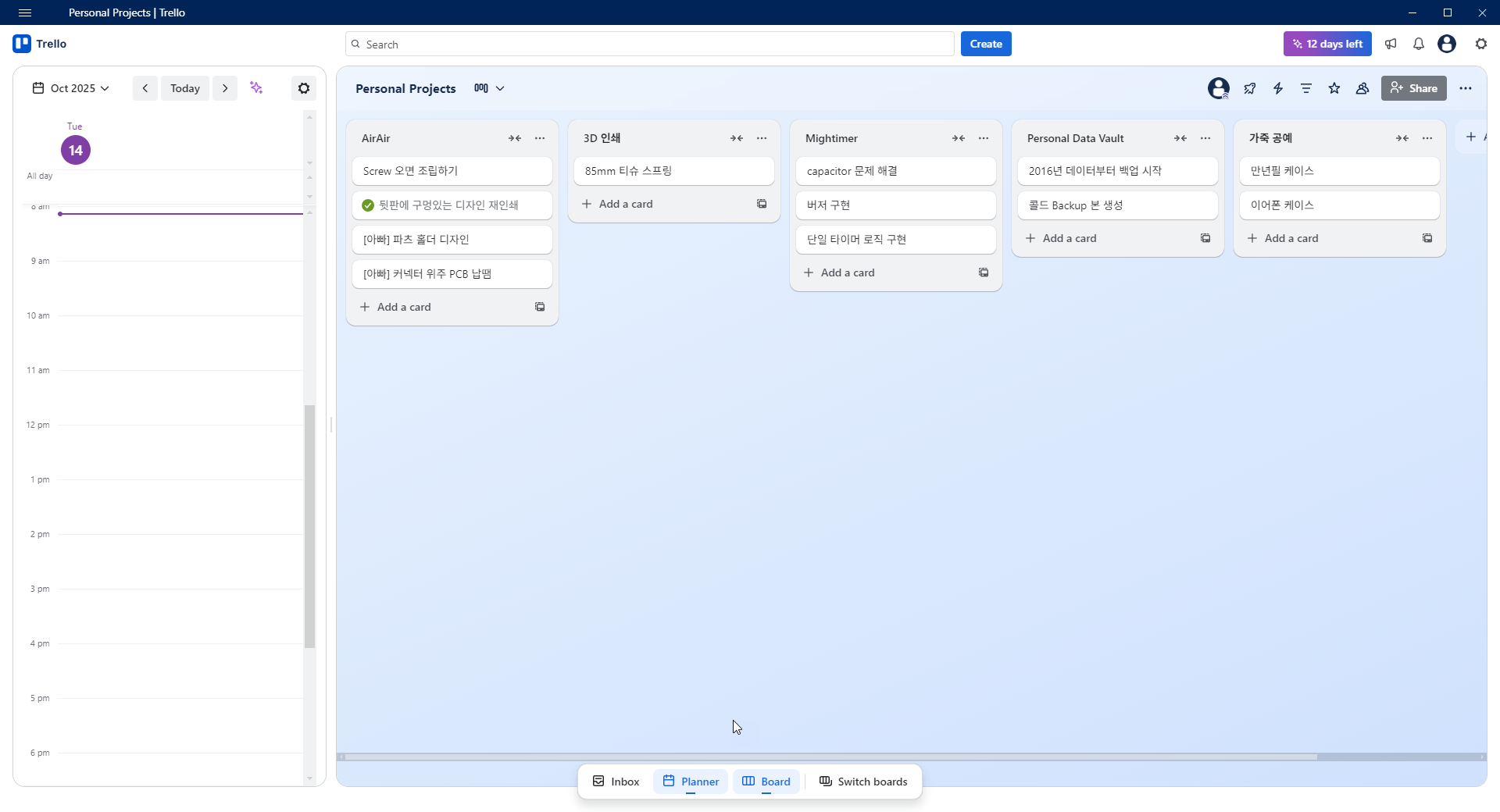

내가 좋아했던 다양한 취미들을 다시 들여다보고, 연구를 하며 늘 고민하던 프로젝트 관리 문제를 해결해보기 위해 이번에는 Trello를 다시 꺼내 들었다.과거 스타트업에서 일하던 시절 여러 프로젝트 관리 도구를 접할 기회가 있었는데, 그때 처음 만난 서비스다. 당시에는 삶도 회사 일도 지금보다 훨씬 단순해서 오히려 불편하게 느껴졌지만, 지금은 그 기능이 꽤 마음에 든다. 아래는 개인 작업용 보드의 스크린샷이다.

미뤄두었던 크고 작은 프로젝트들을 하나씩 마무리하고 있다. 작게는 늘 마음에 걸렸던 서랍장을 고치는 일부터, 오래전부터 구상해온 제품 설계, 가족을 위한 제작 프로젝트까지, 두 달 남짓한 시간 동안 생각보다 많은 것들을 해냈다. 내가 만든 것들로 인해 가족들이 기뻐하는 모습을 보면서, 다시금 '타인으로부터 존재의 의미를 인정받으려는 성향을 지닌, 참 귀찮은 인간'임을 확인했다. 이후에 진행할 연구도 세상에 미칠 긍정적 영향력을 생각하지 않으면 안되게 되었다.

비자 프로세스는 본격적으로 시작이 되었고, 다음주에 건강검진을 앞두고 있다. 이 여유가 언제 끝날지 알 수 없어 불안하지만 주어진 시간을 최대한 후회없이 쓰리라.

미국으로 포닥을 온지 한달이 지났다. 실은 한달하고도 2주가 더 흘렀지만 살면서 가장 분주했던 2주는 없었던 시간처럼 느껴진다. 미국의 주민등록증이자 Social Security Number 발급부터 해서, 입을 옷을 마련하고, 지속가능한 식사 루틴을 짜고, 그리고 제일 중요한 살 장소까지. 정말 많은 일들을 해냈다. 한국에 있으면서 당연하게 누렸던 편의점, 지하철, 은행 시스템들이 이토록 그리웠던 적이 없었다. 그래서인지 정보가 부족했던 과거에, 혹은 더 어린 나이에 미국에 와서 정착하고, 유학을 하거나 연구를 이어간 내가 아는 사람들이 더욱더 대단하게 느껴졌다. 이렇게 한달을 보내면서 나도 조금은 대단해졌을까.

생존에 필요한 것들이 갖추어졌으니, 이 다음 고비는 문화적 차이라고 생각하고 있다. 일하는 태도나 너무 사소해서 아무도 가르쳐주지 않는 사회적 약속, 사람을 대하는 문화 등에서 많은 충돌을 겪을 것을 각오하고 있다. 현재 연구실에는 나와 PI 밖에 없기 때문에 불행인지 다행인지 충돌 자체가 존재하지 않는다.과거 시끌벅적했던 연구실을 떠올리면 지금이 더 심적으로 안정적이지만, 다가오지 않은 학습의 시간들은 나로 하여금 폭풍 전야 같은 기분이 들게 한다. 때문에 '외국인'이라는 틀을 깨고 '한국인이 아닌 사람들'과 최대한 많은 시간을 가져보려고 노력을 하는데 정말 쉽지가 않다. 오늘은 초자아의 부단한 노력으로 극도로 내향적인 자아를 모르는 교수님 연구실에 질질 끌어넣는 것을 성공했다. 덕분에 바로 옆 연구실 사람들을 소개받고, 앞으로 인사를 주고받을 사람들이 늘어났지만, 오늘따라 극도로 피로함을 느끼는 것은 아마 엉망이 된 자아 때문이지 않을까. 미안하다 야.

2주 전 즈음인가 외부 연사 초청이 있다고 관심있는 포닥/학생들에게 점심/저녁 식사 자리 제안이 왔다. 둘다 시간이 된다고 말을 해뒀는데 어쩌다보니 점심/저녁 모두에 참석하는 사람이 되었다. 오늘 알고보니 이런 자리는 5명 내외의 소규모로 진행이 되는 식사자리고 상당히 어색할 수도 있다는 말을 PI에게 들었다. 이제와서 발을 빼기에는 늦었다. 회복을 못한 내향성은 한번 더 고통을 받을 것 같다. 이렇게 자주 고통을 받다보면 조금씩 성장하지 않을까? 언제까지고 모니터 뒤에 숨어있을 수는 없는 노릇이다.

피로감 때문인지 연구라는 행위 자체에 회의감을 살짝 느꼈다. '연구란게 이렇게 힘들면서까지 해야할 일인가'라는 생각이 들더라. 그래도 매일 저녁에 터덜터덜 집으로 돌아오는 길에서 오늘 한 일에 대한 작은 뿌듯함과 앞으로 할 연구에 대한 두근거림을 느낀다. 이것으로 충분할까? 오랫동안 날 앞으로 이끌어줄 연료가 되어줄까? 아마 가치관을 정립한 것은 좋은데, 가치관에 기반한 구체적인 목표를 정립하지 않아서 일지도 모른다. 가치관이 있으면 아예 경로를 벗어나더라도 바른 길로 갈 수 있지만, 작은 하루하루의 deviation 에는 구체적인 목표가 필요할 것 같다. `내가 해야한다` 보다는 더욱 더 강한 동기가 필요하다.

서론

매일 매일이 새로운 문제를 해결하는 날들의 연속이다. (삶도 실험이네 ㅎㅎㅎ)

미국에서 포닥을 시작하며 한국 핸드폰과 번호를 가져가기로 정했다. 하나의 휴대폰에 2개의 sim을 쓰거나 usim을 바꿔끼는 방법도 있지만 분명 자잘한 문제들이 생길 것 같았기에 (나중에 찾아보니 정말 많은 문제들이 생기더라. 모험을 하지 말자 ㅎ) 미국용 공기계를 새로 하나 샀고, 편의점에서 KT 바로유심을 사서 미국으로 갔다.

일주일정도 정착과정을 완료한 후, 한국 핸드폰을 슬 월 1,800원 유심으로 바꾸려고 했다. 여자친구가 셀프개통을 순조롭게 진행했다고도 했고 로밍도 다 되고 wifi도 다 되는데 무슨 문제가 있을까 싶었다.

요약

미국에서 KT Skylife 번호이동은 안된다. 정확히는 번호이동과 개통도 되고 문자 수신도 가능하지만 내 기기가 자신의 번호가 무엇인지 모르게 되고 발신이 제한된다.

단, 번호이동 당일에 한하여 취소를 하면 아무일도 없었던 것처럼 돌아간다. (새로 산 유심은 버리게 되지만)

본론

핸드폰 개통 자체는 핸드폰이 네트워크에 물리적으로 연결되어 있지 않아도 가능하다. 무슨 말이냐면 내 USIM카드의 번호와 핸드폰 번호, 개인정보를 등록하는 것이라 WiFi 만으로도 가능하다. 안그러면 어떠한 네트워크에도 연결을 할 수 없는 공기계에서는 절대 셀프개통이 되지 않을 것.

문제는 개통 완료후 다음 단계가 기기가 번호를 받아오는 과정이다. NAMing, 네밍이라는 과정을 거쳐야 하는데, 이 과정은 국내 네트워크에서 진행이 되어야만 한다 (고객센터 확인). 일부 SK 알뜰폰류에서는 된다는 말을 본적이 있지만 추가 확인이 필요하다.

하나 웃긴것은 개통완료 후에 통신사와 로밍서비스를 제공해주는 해외통신사는 내 핸드폰이 누구인지 알아 문자 수신, 모바일 데이터 사용이 가능하다. 그래서 필자도 재부팅 후 NAMing 과정이 진행되는 동안 문자가 수신이 되는 것을 보고 아무런 문제가 없을 줄 알았다. 그러나 번호등록과정이 끝나지 않고 자꾸 에러를 내뱉으며 다음 단계로 넘어가지 않았다.

사실, 한국 서비스가 필요한 이유는 단 두 가지다. 1)나중에 돌아갔을 때 내 주민등록번호보다도 중요한 핸드폰 번호를 킵할 수 있을 것. 2) 본인인증을 할 수 있을 것. 때문에 문자 수신도 잘 되는데 언젠가 한국에 방문할때 번호를 받아오면 되지 않나도 생각을 했었다. 그러나 가장 빨리 나가도 3개월 뒤의 일이었기 때문에 일단 고객센터에 문의를 넣었다. 일부 후기에서 고객센터에서 강제 등록을 해서 해결한 케이스도 있다고 했다. (그런데 아마 이번처럼 핸드폰이 자기 번호를 못 받아오는 케이스는 해당되지 않을 것 같다.

여자친구의 도움으로 KT Skylife에 전화를 해서 알아본 결과 해외에서 번호이동은 불가능하며, 번호이동 당일에는 Ctrl+Z가 가능하다는 정보를 받았다.

KT Skylife의 경우 해외에서 고객센터 전화가 다 막혀있고, 아래 번호만 작동을 한다. (도대체 어디에 있는 번호지? 왜 못찾았지..)

+82-2-2620-5000

아래로 전화를 걸어 당일 번호이동 취소를 하면 일단 이전 서비스로 복구가 가능하다. 대신 한번 등록기록이 있기에 새로운 USIM은 사용하지 못한다고 한다.

모두 번호이동은 국내에 있을 때 하시길....

서론

절망적인 독서량을 고려해서 자기개발서류는 가능하면 시작조차 하지 않는다. 정말 유명한 책이 나왔다고 하더라도 실제 주장하는 바는 2%, 나머지는 왜 이러한 방법이 좋은지를 설명하는 것에 그치기에 시간을 들여 다 읽을 필요는 없다고 생각한다. 주장만 납득이 된다면 나머지를 전혀 읽지 않아도 아는 것에는 지장이 없을 터이니. 문제는 이를 실천하는 쪽이겠지만 말이다.

대학원생 생활을 하면서 본인의 장기프로젝트 진행 능력이 거의 0에 가까움을 뼈저리게 깨달았다. 성과를 평가할 확실한 metric 이 없고, 중간 평가도 존재하지 않으며 (실험을 배우는 단계에서는 논문도 좋은 metric으로는 기능하지 않는다) , 연구란 것이 어느 수준에서 불완전한 상태로라도 마무리 하지 않으면 끝이 나지 않기에 대학원생이야 말로 뚜렷한 장기 계획 능력이 필수이다. 혹 과거로 돌아가 다시 석박통합과정을 처음부터 시작하게 된다면 온갖 시행착오를 겪더라도 무엇보다 이 능력을 갈고 닦을 것이다.

때문에 조금이나마 문서화된 도움을 얻고자 이 책을 읽게 되었다. 일부는 내가 이미 시험삼아 실행했다가 생각보다 엄청난 효과에 놀라고 있던 것이었고, 일부는 당연하다고 여기는 것들, 또 일부는 효과가 있을까 의문이 생기지만 해볼만한 가치가 있는 방법들이었다. 이 중 당연하다고 여기는 파트들은 빠른 속도로 스킵하면서 넘겼기에 독서록에 기록한 부분이 그리 많지 않다. 몇몇 내용들을 내 생각들을 추가해서 아래 정리해본다.

계획 세우기

버킷리스트와, 마스터 플랜, 액션 플랜, To Do list를 구분하자.

버킷리스트는 인생 단위로 봐서 이루고 싶은 꿈들을 현실성과는 상관 없이 정한다. 단, 보통 버킷리스트에 쓰는 '스카이 다이빙 해보기' 마냥 가벼운 것들이 아니라 삶의 목적이 될만한 것들로 채운다.

다음은 10-20년 단위의 마스터 플랜을 정한다. 특정 직업을 얻기, 무언가 만들어 내기 처럼 큰, 하지만 현실성이 있는 목표들이 여기에 해당된다.

액션 플랜은 마스터 플랜을 달성하기 위한 길게는 1년 단위의 더 세부적인 목표이다. 논문 쓰기, 책 출간하기 등이 여기 해당된다.

To Do list는 이를 달성하기 위해 오늘 끝낼 수 있는 일들의 목록이다. 논문의 결론 파트 한 문단 작성 등이 여기 해당 된다.

버킷리스트와 마스터 플랜의 조건

종이에 기록하는 것이 도움이 된다. 왜 인지는 모르겠지만, 감정적인 정리가 필요할 때에는 꼭 종이와 만년필을 꺼내든다. 그렇게나 글을 쓰기 싫어하는 학생이었는데 아직까지 생각 정리를 함에 있어서 종이와 펜 이상의 것을 찾지 못했다.

To Do List의 조건

SMART 원칙이라는 것이 괜찮은 기준인 것 같다. Specific, Measurable, Attainable, Relevant, Time-bound

이 중 specific과 time-bound가 내게 있어서 가장 어려운 파트다. 생각보다 스스로 큰 덩이의 일을 할 수 있다고 생각하고 너무 크게 To Do List를 잡으며, 여기 걸릴 시간도 너무 낙관적으로 짧게 잡는다. 물론 호프스태터의 법칙이 있듯이 비관적으로 생각하여 길게 잡아도 이보다 오래 걸리겠지만... 메타인지 훈련을 위해서라도 꼭 To Do List 안에는 완성에 필요한 시간을 적어두는 것이 좋다.

Specific To Do List

링피트를 하는 습관을 만드려고 시도했던 것 중에 하나가 To Do List를 아주 단순하게 만드는 것이었다. "운동하기", "매일 링피트 30분을 하기" 이런 것이 아니라 무려 "하루에 한번 닌텐도 스위치 켜기" 였다. '이걸 못할 수는 없지' 수준으로 To Do 를 만들면 양심에 찔려서라도 그 뒤를 할 수 있게 되더라. To Do 를 잘 못지키게 되는 것 같으면 더 세세한 단위로 쪼갤 필요가 있다. 아래는 기억해두면 좋을 말들이라 적어둔다.

소설을 쓰는 것은 밤에 자동차를 운전하는 것과 같다. 당신은 차의 헤드라이트가 비춰주는 데까지만 볼 수 있을 뿐이다. 헤드라이트가 비춰주는 곳까지 달리다 보면 목적지까지 갈 수 있다. - E. L. 닥터로우

You solve one probelm and you solve the next one, and then the next. And If you solve enough probelms, you get to come home. - Martian

역산 스케줄링

이것도 어려워 하는 파트 중 하나이다. 특히 상황이 절망적이면 큰 그림을 보려고 하지 않고 자꾸 '그냥 지금 열심히 하자' 수준에서 일을 수행한다. 꼭 액션 플랜을 기억하며 Dead Line을 정하고 이를 기반으로 To Do List를 짜야한다. 짜야 하는데..

전날 밤에 내일 할 일 생각하고 써두기

시험 삼아 시도했다가 엄청난 효과를 봤었는데, 이 책에도 비슷한 내용이 짧게 소개되어 있었다. 전형적인 야행성 인간이라 그런지 아침에는 집중도 안되고 큰 범위의 생각이 어렵다. 때문에 전날에 멍청해진 오전의 자신을 위해 무지성으로 해야할 일들 리스트를 적고, 다음날 졸린 나는 하라는 대로 일을 하기 시작했는데, 오전 시간의 효율을 정말 높여주었다. 한가지 특이점은 앱에 기록해두면 잘 쓰지 않고 꼭 종이에 기록해서 아침에 학교에 가며 가져가도록 하는 쪽이 효과가 좋았다는 점이다.

계획 실행하기

계획 실행의 1/3 정도는 계획 수정이다.

무엇을 하더라도 결국 계획은 실제 실행 내역과 어그러지게 된다. 그렇게 실제 실행 내역을 보고 계획을 수정하는 일을 계혹 하다보면 애당초 맞지도 않을 계획을 왜 짰나 싶을 정도로 낙담하게 된다. 이것은 과연 효과가 있을 지 모르겠지만, 현실을 부정하지 않고 계속 계획 수정을 하는 것을 지속해봐야 겠다.

결론

계층적인, 그리고 시간을 정할 수 있는 할일 나누기가 관건인것 같은데 최근 마음에 드는 사이트를 하나 찾았다. 2주 정도 사용을 해보고 마음에 들어 별 기능도 없는 사이트지만 한달치를 일단 결제해 사용해보기로 했다. 사이트는 아래와 같다.

Quire - The ultimate project management software for teams

The best project management software that actually helps remote teams plan, collaborate, get focused and get things done.

quire.io

To Do List를 계층적으로 만들 수 있고, 전체적인 일의 흐름도 볼 수 있다. Timeline view가 유료 전용이라 아쉽지만, 일단 대체제를 찾기 전까지는 이 사이트를 사용해볼 생각이다.

'기록 > 책' 카테고리의 다른 글

| 장 프랑수아 마르미옹의 <내 주위에는 왜 멍청이가 많을까>를 읽고 (0) | 2022.12.19 |

|---|---|

| 달라이 라마의 <종교를 넘어>를 읽고 (0) | 2022.11.28 |

제목과 표지만으로 책장에 꼽아두었더니 가치를 충분히 수행했던 책이다. 간접적인 방법으로 주변 사람의 멍청함을 당당하게 욕하는 통쾌함과, 주변인들의 다양한 반응을 구경하는 재미, (’이거 나 보라고 꼽아둔거지!’, ‘너도 멍청할 때가 있잖아!’, ‘아니야 이거 분명 저 사람을 멍청하다고 말하고 싶었던 것일꺼야’) 그리고 가볍게 읽을 수 있는 내용의 셋을 챙길 수 있다. 물리적인 책의 존재로 오는 만족감이 있었기 때문에 전자책인 경우 1/5점, 종이책인 경우 4/5점을 주고 싶다.

전반적인 내용은 다양한 저널리스트, 심리학자, 칼럼리스트, 작가 들에게 멍청함에 대한 글을 요청하거나 멍청함에 대한 인터뷰를 요청하고 그 내용을 모은 모음집이다. 제목 때문에 멍청함에 대한 심도깊은 탐구가 있을 것이라 기대했는데 그렇지는 않았다. 생각해보니 내게 ‘인간의 멍청함’을 연구해보라고 하면 도대체 어디서부터 시작해야할지 감도 못잡을 것 같다. 때문에 내용이 난잡하게 얽혀있고, 멍청함과 관련된 뇌 영역을 이야기하는 글 부터 육식의 멍청함을 이야기하는 글까지 다양한 내용이 통일성 없이 섞여있다. ‘책’이라기 보다는 ‘멍청함을 주제로한 잡지 특별호’ 의 느낌이 더 가까울지도 모르겠다.

프랑스 인들의 글의 비중이 상당히 높았는데, 이들의 문화적 특성으로 보이는 모습을 얼핏 볼 수 있었다. 바로 얼마전 미국인이 쓴 조금은 딱딱한 내용의 책을 읽어서인지 유독 많은 글들이 그림, 소설 등으로부터 내용전개를 시작하는 것처럼 보였다. 안타깝게도 대부분의 내용은 멍청함을 다양한 방식으로 욕하고 ‘그들을 구제해줄 수 없으니 피해라’ 식의 결론을 내리는 터라, 소개된 그림이나 책들을 찾아보는 쪽이 더 즐거웠던것 같다. 심리학과에 있으면서 이름을 한번쯤은 다 들어본 유명한 교수들도 인터뷰가 있었는데, 과학자답게 질문이 충분히 세부적이지 않으면 “그럴 수도 있고 아닐 수도 있죠. 이런 결과도 있고 아닌 결과도 존재합니다.” 식이었다. 앞서 말했듯이 잡지를 읽는 느낌으로 읽어야 온전히 책을 즐길 수 있을것 같다.

그나마 진지함이 느껴졌던 글은 세바스티아 디게 교수의 글로 멍청함의 근원을 철학자 해리 프랑크푸르트의 말을 인용하며 멍청함은 “진실에 대한 관심부재”에 기인한다고 이야기 했다. 내가 생각해도 지능 부족으로 진실을 이해할 여력이 되지 않는 것을 넘어, 진실 그 자체에 관심이 없거나, 진실 여부와는 상관없이 다른 것에 목적이 있는 경우에는 분명 행동이 멍청해지는 것 같다. 이렇게 전문성이나 지능과는 상관 없이 “관심의 부재”로 인해 누구나 멍청해 질 수 있기에, 대다수의 글들에서 ‘누구나 다 멍청해질 수 있음을 잊지 말고 자기 비판적인 사고를 해야한다.’ 고 결론을 내린다. 안타깝게도 어떤 글도 미래에는 멍청함이 줄어들 것이라는 낙관적인 예상을 하지 않는다. 인류는 결국 멍청함과 함께 해야만 하는 존재인가.

'기록 > 책' 카테고리의 다른 글

| 정경수의 <계획 세우기 최소원칙>을 읽고 (0) | 2023.01.23 |

|---|---|

| 달라이 라마의 <종교를 넘어>를 읽고 (0) | 2022.11.28 |

서론

종교를 가지고 있지만 불가지론을 지향하는 과학자로서 (제목과는 다르게 아이러니 하게도) “종교 서적”으로 분류된 이 책을 스스로 읽을 이유는 전혀 없었다. 단지 최근에 읽은 Ray Dalio의 <Principle>에서 이 책을 인용했다는 점과, 종교 최대 지도자가 종교를 “넘어”라는 표현을 썼다는 점이 신경쓰여서 책을 잡아들게 되었다. 전체적으로는 내가 자기개발서에 기대하는 수준을 넘기지는 못했으나, 여러가지 생각할 점들을 주었다는 것과, 얇은 책 두께 때문에 읽은 시간이 아깝지는 않았다.

종교의 몰락.

종교에는 신에 의해 진실이 보장된 도덕이 있고, 사후세계에서의 심판이든 다음 생에서의 삶이든 옳음을 강요하는 강력한 힘이 존재한다. 그러나 세계화로 종교간의 의견 충돌이 보이기 시작했고, 종교들이 제시하던 도덕 또한 ‘상대적 진실’에 불과하다는 점이 드러나면서 종교는 예전처럼 힘을 쓰지 못하게 되었다. 또한 순기능에 비해서 점점 비대해지는 종교에 반해서 생겨난 과학의 등장으로 종교의 가치는 점점 하향세를 걷고 있다. 확실하지 않으면 존재 자체를 부정하는 과학을 하는 하는 내 입장에서 이러한 변화는 자연스러운 것이며, 종교는 결국 일부 쇠퇴하리라고 생각한다.

마음챙김은 그러면 이제 누가 어떻게?

문제는 종교의 몰락이 아니라 종교가 원래 수행하던 일을 어떤 객체가 이어서 수행을 하냐는 것이다. ‘마음’이든, ‘내적 가치’든, ‘자비’든 인간의 온전한 정신상태는 인류에게 단 한번도 중요하지 않았던 적이 없었다. 단지 과거에는 종교가 이러한 일들의 일부를 담당하고 있었으나 종교의 몰락과 함께 마음챙김(이 단어를 매우 싫어하지만 적절한 단어를 찾지 못해서 그대로 사용한다)을 담당할 무언가가 사라지고 있다. 이 책에서 마음챙김의 중요성을 첫 챕터에서 지적을 하는데, 달라이 라마도 종교의 한계를 인정하지만, 그렇다고 종교가 원래 해오던 일들까지도 함께 무시해서는 안된다고 이야기한다. 때문에 이 책의 제목이 종교를 “넘어” 인 것이다. 역자의 후기를 읽어보면 달라이 라마가 어느날 갑자기 이러한 이야기를 한 것이 아니라 꽤 오래전부터 종교 그 이상의 가치를 지켜야한다고 역설해온 것으로 보인다. 어쩌면 불교가 종교의 많은 구성 요소를 자기 수행과 온전한 정신상태에 초점을 두고 있기에 가장 먼저 종교의 부재로 발생하는 문제점들을 인식한 것이 아닌가 생각한다. 개신교에 익숙한 나로서는 단 한번도 종교의 약체화가 인류에게 이러한 영향을 미치리라고 생각을 해본 적이 없었다. 확실히 다양한 가치가 자유와 다양성이라는 이름하에 수용이 강제되고 있고, 더이상 흑백논리적 도덕적 판단이 어려워지는 현재에 있어서 설사 그것이 상대적 진실이라고 하더라도 기준점이 되어줄 무언가가 절실히 필요하다. 무엇이 옳고, 우리가 어떤 정신을 가지고 어디에 더 중점을 두어야 하는지를 생각하는 것이 더 중요해졌다.

달라이 라마의 대책

그렇다면 어떤 객체가 기존의 종교가 맡아서 하던 마음챙김의 역할을 대신 해줄 수 있을까. 우리가 나아가야할 방향을 확실히 제시해주고, 좀 더 일관되고 올곧은 현세적 도덕관을 제시해주며, 한 사람 한 사람을 위로해줄 수 있는 무언가가 나타난다면 그 형태가 어떻든 간에 21세기에 가장 강력한 ‘종교’가 될 것임이 분명하다. 책의 2/3을 할애하는 부분은 달라이 라마의 대책이다. 안타깝게도 달라이 라마 본인에게 가장 익숙한 불교적 방법, 스스로의 수행과 명상을 통한 자비에 기반한 마음챙김을 해법으로 제시한다. 인류를 하나로 묶어주는 강력한 대상이 없어지는 만큼 ‘각자도생으로 자기 마음은 자기가 챙기자’의 논리가 틀린 것은 아니겠으나, 뻔한 자기 개발서의 흐름을 벗어나지 못했다는 생각에 아쉬움이 앞섰다. 아무리 자애로운 마음이 무엇인지, 절제와 덕이 무엇인지를 설명해도 달라이 라마 본인의 말처럼 이는 ‘지식의 문제가 아니라 행동의 문제’이다. 책을 통해 조금이나마 방향을 잡아주지 않을까 하는 기대를 했으나, 스스로 깨닫고 행동하지 않으면 알 수 없는 내용들에 대한 설명만이 마지막 페이지까지 이어졌다. 그나마 다루는 내용의 무게에 비해 얇은 두께로 그가 이런 한계를 인지하고 최대한 ‘절제’를 해서 글을 썼다는 점을 느낄 수 있었다.

총평

전혀 관심을 주지 않을 법한 주제와, 다른 종교의 사고관을 간접적으로 나마 접할 수 있었다는 점에서 충분히 읽을 만한 책이었다. 특히 종교의 부재로 일어나는 일에 대해서는 단 한번도 생각을 해본 적이 없었으나, 이 책을 읽고 달라이 라마의 염려에 확실히 동의할 수 있었다. 그리고 내가 접해본 종교인들은 본인의 ‘옳음’에 심취되어 있거나, 다른 분야에 대한 무지로 헛소리를 하는 경우가 대부분이었는데 달라이 라마는 확실히 다른 것 같다. 열린 마음으로 다양한 학문을 탐구하고, 자신의 종교와의 공통점을 찾고, 더 나아가서 자신의 종교 그 이상의 메타적인 시각에서 인류를 조망하는 것이 확실히 느껴졌다.

'기록 > 책' 카테고리의 다른 글

| 정경수의 <계획 세우기 최소원칙>을 읽고 (0) | 2023.01.23 |

|---|---|

| 장 프랑수아 마르미옹의 <내 주위에는 왜 멍청이가 많을까>를 읽고 (0) | 2022.12.19 |

2D Gaussian Convolution filter

2D space에서 image smoothing, noise 제거 등을 위해서 Gaussian filter를 적용할 때가 있다.

Matlab에는 워낙 다양한 toolbox들이 있어서 간혹 유사한 기능을 하는 함수들이 존재하기도 하는데, 때문에 같은 기능을 다양한 방식으로 구현을 할 수 있다.

오늘 imgaussfilt 함수와 mvnpdf 함수를 사용해서 Gaussian filter를 적용을 하다가 몇가지 차이점과 유의점을 발견하여 이곳에 적는다.

Original Image

코드 설명에 사용할 Original Image를 만드는 코드이다.

100 x 100 이미지에 (50, 50) 과 (20, 50) 의 pixel만 1의 값이 들어가있다.

originalImage = zeros(100,100);

originalImage(50, 50) = 1;

originalImage(20, 50) = 1;Method 1: imgaussfilt

함수 개발 목적 자체가 2D 이미지에 Gaussian filter를 적용하기 위한 것이기 때문에 가장 간단하게 원하는 목적을 달성할 수 있다.

figure(1);

clf;

sigma = 1;

fimage1 = imgaussfilt(originalImage, sigma, 'FilterSize', 101);

imagesc(fimage1);여기서 중요한 것은, 'FilterSize' Name-Value pair인데, 이 값을 입력하지 않거나, 작은 값으로 설정하는 경우 convolve 하는 kernel의 크기가 작아서 빠르지만 조금은 부정확한 결과가 나올 수 있다.

참고로 fimage1의 합은 2가 된다.

Method 2: mvnpdf로 kernel을 만든 뒤 conv2

직접 2D Gaussian kernel을 만든 뒤에 원본이미지와 conv2 함수를 사용해서 적용하는 방식이다.

[X,Y] = meshgrid(1:101, 1:101);

X = X(:);

Y = Y(:);

mu = 51;

sigma = [1, 0; 0, 1];

kernel = reshape(mvnpdf([X,Y],mu,sigma),101, 101);

fimage2 = conv2(originalImage, kernel, 'same');

figure(2);

imagesc(fimage2);51의 값은 101 크기의 kernel의 중간값이다.

위 결과는 imgaussfilt의 결과와 정확히 일치한다.

함수 개발 목적 자체가 2D 이미지에 Gaussian filter를 적용하기 위한 것이기 때문에 가장 간단하게 원하는 목적을 달성할 수 있다.

'취미 > Technology' 카테고리의 다른 글

| 안녕 Evernote (0) | 2026.01.26 |

|---|---|

| Notion 입문 1달차 (0) | 2022.02.23 |

| tensorflow에서 시작하는 pytorch 작동 방식 (iris example) (0) | 2022.02.03 |

| Notion 입문 1일차 (0) | 2022.01.11 |

| 웹캠이 흑백으로 나와요. 해결방법(feat. 뒤늦은 삼성 노트북 A/S 후기) (3) | 2021.08.19 |